En 2017, une entreprise de thé glacé basée à New York a déclaré qu'elle "pivotait vers la blockchain", et son action a bondi de 1,5 milliard d'euros. 200%.

J'en parle parce que, six ans plus tard, AI est comme bourdonnant Aujourd'hui, l'IA est aussi importante que la blockchain l'était à l'époque. Les services marketing ont coopté le terme au point que la signification de l'"IA" - et, plus important encore, la manière dont elle peut réellement renforcer la cybersécurité - peut se perdre dans le bruit.

Cela m'est apparu clairement lors de la conférence KuppingerCole Conférence européenne sur l'identité et l'informatique dématérialisée 2023, où j'ai présenté le potentiel de l'IA pour empêcher la prise de contrôle de comptes. L'IA ne se résume pas au battage médiatique, mais sa valeur réelle en termes de renforcement de la cybersécurité et de rapprochement des organisations vers la confiance zéro peut être noyée dans tout le battage médiatique.

Définissons donc nos termes et entrons dans le vif du sujet. Passons en revue quelques-unes des façons dont la cybersécurité peut réellement utiliser l'IA pour traiter les données d'authentification, d'habilitation et d'utilisation. Et définissons le type d'IA le plus à même d'améliorer la position d'une organisation en matière de cybersécurité.

La cybersécurité a tendance à être subdivisée en compétences de base : l'authentification multifactorielle (AMF) pour sécuriser l'accès, la gouvernance et l'administration des identités (AGI) pour appliquer le principe du moindre privilège, la gestion des incidents et des événements de sécurité (SIEM) pour surveiller l'utilisation, etc.

Chacune de ces compétences est hautement spécialisée, déploie ses propres outils et protège contre des risques différents. Ce qu'elles ont en commun, c'est qu'elles produisent toutes des montagnes de données.

Prenons l'exemple de l'identité, qui compte de plus en plus d'utilisateurs, d'appareils, de droits et d'environnements. Dans un 2021 plus de 80% des personnes interrogées ont déclaré que le nombre d'identités qu'elles géraient avait plus que doublé, et 25% ont fait état d'une multiplication par 10.

L'identité devient rapidement un problème de données : il y a plus d'informations que les humains ne peuvent en traiter. C'est la raison pour laquelle l'IA peut être un atout important : l'IA peut rapidement donner un sens à de grandes quantités de données, à condition de formuler correctement la question et de savoir ce qu'il faut demander à l'IA.

Voici les trois questions que les professionnels de la cybersécurité peuvent utiliser pour prévenir les risques et détecter les menaces :

#1. Authentification : utiliser l'IA pour comprendre qui essaie d'entrer.

L'IA peut traiter les données d'authentification pour déterminer qui tente de s'authentifier dans votre système. Pour ce faire, elle examine le contexte de chaque utilisateur, notamment l'appareil qu'il utilise, l'heure à laquelle il tente d'accéder au système, l'endroit d'où il accède au système, etc.

L'étape suivante consiste à utiliser ces informations actuelles et à les comparer au comportement passé de l'utilisateur en question : si je m'authentifie cette semaine à partir du même ordinateur portable, aux mêmes heures et à partir de la même adresse IP que la semaine dernière, mon contexte sera probablement assez bon.

Par ailleurs, si quelqu'un qui prétend être moi essaie de se connecter à partir d'un nouvel appareil à 3 heures du matin et d'une nouvelle adresse IP, l'IA devrait automatiser l'authentification par étapes pour contester ce comportement suspect.

Au contraire, l'IA doit constamment réévaluer ses décisions pour refléter le comportement global des utilisateurs et des organisations et s'adapter à ce qui semble "normal". Le comportement des utilisateurs évolue en permanence et l'IA doit toujours en tenir compte.

Les ensembles de règles statiques ne sont pas assez fins pour tenir compte du contexte individuel et manquent de la profondeur des données de référence nécessaires pour automatiser les actions en toute confiance.

Ou, pour le dire autrement : les ensembles de règles statiques ne seront pas en mesure de savoir s'il est normal que je tente de me connecter pour le 8th à moins de 60 minutes de l'Allemagne à 23:00. Peut-être est-ce un comportement normal pour moi, ou peut-être est-ce louche. Quoi qu'il en soit, les règles statiques ne permettront pas de le savoir.

Depuis près de 20 ans, RSA utilise des algorithmes d'apprentissage automatique et des analyses comportementales pour aider les clients à définir ce qu'est un "bon" ou un "mauvais" contexte et à automatiser les réponses aux comportements des utilisateurs. RSA Risk AI traite la grande quantité de données générées par les utilisateurs pour compléter les techniques d'authentification et d'accès traditionnelles et aider les entreprises à prendre des décisions d'accès plus intelligentes, plus rapides et plus sûres à grande échelle.

#2 Compte et droit : utiliser l'IA pour savoir à quoi une personne peut avoir accès

L'IA traite les données d'authentification pour le savoir qui tente d'y accéder. Il examine les données relatives aux comptes et aux autorisations afin de répondre à une autre question : quel est l'objectif de l'utilisateur ? pourrait l'accès à quelqu'un ?

Les robots répondent à cette question en examinant les comptes et les droits des différentes applications. Cela permet aux organisations de s'orienter vers la notion de moindre privilège (un élément important de la confiance zéro). Cela peut également aider les organisations à identifier toute violation de la séparation des tâches.

Pour les humains, le traitement des informations relatives aux comptes et aux droits est pratiquement impossible : les enregistrements relatifs aux droits peuvent rapidement atteindre des millions. L'examen manuel de ces données est voué à l'échec - un examinateur humain appuierait probablement sur "Approuver tout" et s'en tiendrait là.

Mais si l'examen approfondi des droits demande beaucoup d'efforts, il est aussi très utile, en particulier pour renforcer la cybersécurité. Parce que les humains sont si prompts à appuyer sur le bouton "Tout approuver", nous créons des comptes qui ont beaucoup plus de droits qu'ils n'en ont besoin. 2% des droits sont utilisés.

Les risques liés à ces droits augmentent au fur et à mesure que les entreprises intègrent davantage d'environnements en nuage : Gartner prévoit que "la gestion inadéquate des identités, des accès et des privilèges sera à l'origine de 75% de défaillances de la sécurité de l'informatique en nuage" cette année, et que la moitié des entreprises exposeront par erreur certaines de leurs ressources directement au public.

Les organisations peuvent trouver des informations précieuses - comme les utilisateurs aberrants - en recherchant dans leurs données de droits. Les utilisateurs aberrants ressemblent beaucoup à d'autres groupes d'utilisateurs, mais présentent des combinaisons de droits qui les rendent différents. Ces différences peuvent ne pas être aussi évidentes qu'une violation de la séparation des tâches, mais elles peuvent être suffisamment significatives pour que l'IA les reconnaisse. Un examen des accès se concentrerait sur ces utilisateurs aberrants - et non sur les autres 99% d'utilisateurs dont les droits sont considérés comme moins risqués ou qui ont eu les mêmes droits approuvés précédemment.

Trouver ces petites aiguilles dans toutes ces énormes bottes de foin est facile pour l'IA et pratiquement impossible pour l'homme.

#3. Utilisation de l'application : Utiliser l'IA pour savoir ce que fait réellement une personne

L'IA examine les données d'authentification pour déterminer qui tente d'obtenir l'accès. Il examine les données relatives aux droits pour comprendre ce qu'une personne peut faire pour obtenir un accès. pourrait l'accès.

En ce qui concerne les données relatives à l'utilisation des applications, l'IA tente de répondre à la question de savoir ce qu'une personne fait réellement... fait.

Il existe un flux constant de données en temps réel incroyablement utiles dans toutes les applications et tous les composants de l'infrastructure d'une organisation : une IA pourrait voir quelles ressources j'ai réellement utilisées pour écrire ce billet de blog, à qui j'ai demandé de l'aide, les données que j'ai consultées, les applications que j'ai utilisées, et ainsi de suite. Ces informations renseignent mon organisation sur ce que je fais et sur les étapes dont j'ai réellement eu besoin pour y parvenir.

Il est important de noter que cette analyse peut également révéler des activités incorrectes, illégales, non conformes ou risquées : ce n'est pas parce qu'un utilisateur dispose légitimement d'un droit qu'il doit devrait. L'IA peut traiter les données d'utilisation des applications pour trouver ces erreurs et les corriger. Certes, vous avez les droits d'accès à ce site SharePoint sensible, mais pourquoi téléchargez-vous un grand nombre de fichiers à partir de ce site au cours des 30 dernières minutes ?

Il existe deux grands types d'IA : déterministe et non déterministe. L'apprentissage automatique est principalement une IA déterministe. Il est le plus efficace pour traiter des données structurées. L'apprentissage profond (Deep Learning) est souvent un type d'IA non déterministe qui est le plus efficace pour traiter des données non structurées.

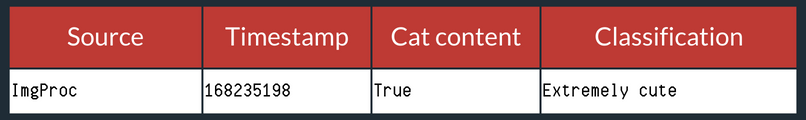

Une autre façon de le dire : L'apprentissage profond serait capable de regarder cette image et de répondre à la question "Où se trouve le chat dans l'image ?".

L'apprentissage automatique serait en mesure d'examiner un fichier journal et de répondre à la question suivante : "Que s'est-il passé à l'heure indiquée 168235198 ?".

En matière de sécurité, que vous essayiez d'utiliser l'IA pour évaluer l'authentification, les droits ou les données d'utilisation des applications, les informations que nous examinons sont presque exclusivement des données structurées.

Cela signifie que, dans une large mesure, nous voulons utiliser l'apprentissage automatique, ou l'IA déterministe, dans le domaine de la cybersécurité. L'IA déterministe peut traiter les données que nous lui transmettons de manière plus transparente que l'IA non déterministe. "Plus transparente" parce que, soyons réalistes, nous n'avons pas tous (moi y compris) les connaissances mathématiques avancées nécessaires pour connaître tous les détails. En revanche, beaucoup de gens en ont, et un modèle de ML déterministe peut leur être expliqué dans son intégralité.

Il y a recherche afin de mieux comprendre le fonctionnement des IA non déterministes. Je suis curieux de savoir où cela nous mènera et si nous finirons par comprendre complètement le fonctionnement des réseaux neuronaux et des autres IA non déterministes.

Les résultats produits par l'IA déterministe sont tout aussi importants que le traitement de ces entrées structurées. L'IA non déterministe est davantage une boîte noire : nous, les humains, ne pouvons pas savoir exactement comment une IA non déterministe a produit une image donnée, par exemple. Il y a l'entrée au début, la sortie à la fin, et si vous ouvriez cette boîte noire au milieu, vous verriez un pays imaginaire de dragons et de licornes : c'est tout simplement un mystère.

Avec l'IA déterministe, nous pouvons savoir comment notre modèle est parvenu à sa réponse. Théoriquement, nous pourrions vérifier le travail d'une IA déterministe et introduire manuellement les mêmes données pour obtenir la même réponse. C'est juste que faire cela manuellement nécessiterait une quantité inimaginable de papier, de café et de santé mentale, et que cela ne peut pas être fait en temps réel.

Pour les équipes de sécurité et d'audit, cette transparence et la compréhension du fonctionnement de l'IA sont essentielles au maintien de la conformité et à l'obtention de certifications.

Cela ne veut pas dire que les algorithmes non déterministes ou d'apprentissage profond n'ont aucun rôle à jouer dans la cybersécurité. Il y en a : l'apprentissage profond peut trouver des réponses que nous n'avons pas cherchées et peut être utilisé pour améliorer les modèles déterministes. Les professionnels de la cybersécurité devraient accorder une grande confiance à cette boîte noire et à ce qu'elle produit.

Nous misons beaucoup sur l'IA et pensons qu'elle peut jouer un rôle important dans le renforcement de la cybersécurité.

L'authentification, l'accès, la gouvernance et le cycle de vie doivent collaborer pour protéger l'ensemble du cycle de vie de l'identité.

En combinant ces fonctions dans un plate-forme d'identité unifiée aide les organisations à protéger les angles morts qui résultent des solutions ponctuelles ; elle crée également plus de données pour former l'IA à quelque chose d'encore plus intelligent.